De wilde wereld van XR en privacy in het onderwijs

Tijdens de Wild World of XR & Privacy-sessies kijken we - leraren/gebruikers en privacyprofessionals samen - wat er nodig is om deze technologie qua privacy veilig in te zetten voor de studie. Tijdens de eerste meeting op 13 juni maakten we kennis met de werking van XR (extended reality) in samenhang met privacyaspecten. In dit artikel kijken we daar nog eens naar, zodat je je alvast kunt inlezen of je kennis kunt opfrissen voor de volgende sessie.

Waarom praten we hier eigenlijk over?

XR, extended reality, is de parapluterm voor realistische digitale situaties via augmented reality, virtual reality en mixed reality. Door dingen 3D te kunnen bekijken, open je de deur van een heel nieuw leerproces. Dat kan via serious games, die speciaal zijn ontworpen om te leren en soms om gedrag te veranderen. Dit gaat gemakkelijker met XR vanwege de meeslepende ervaring. XR biedt dus de mogelijkheid om gedrag te begrijpen en te veranderen. Dit biedt mooie kansen voor het onderwijs. Maar de techniek kan ook worden misbruikt, zeker als we niet goed weten hoe het werkt.

Voor een goed studieprogramma hebben we functionaliteit nodig die efficiënt is, maar die we ook veilig kunnen inzetten. Dat is best een uitdaging, want het terrein is redelijk onverkend. Maar juist omdat XR-technologieën zich nog in een vroeg stadium bevinden, zijn er ook kansen om proactief oplossingen te ontwikkelen.

De samenhang met privacy

Leraren willen de techniek graag inzetten omdat het hen de functionaliteit biedt die bij uitstek hun studenten helpt om te leren. Privacyprofessionals kunnen met hen meedenken zodat dit op een verantwoorde manier gebeurt. Het datalek bij Clinical Trials laat nog een keer duidelijk zien hoe naar het is als gegevens worden ontfutseld. Dus, of je wilt of niet, je moet nadenken hoe je de risico's laag houdt voor je studenten. Een veilige leeromgeving is immers niet alleen fysiek maar ook digitaal belangrijk.

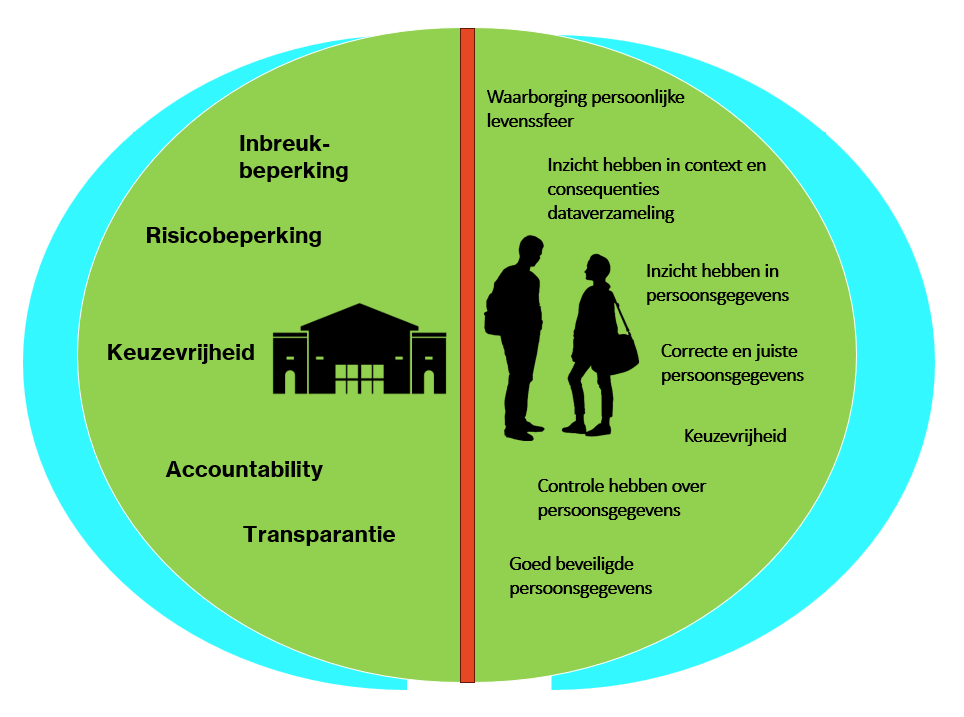

Wat maakt dit gesprek nu zo lastig? Medewerkers willen gewoon graag hun werk doen. De belangen van hun werkgever en die van de student (en de privacyprofessional) liggen op een ander vlak. Het is daarom cruciaal dat de leraar en de privacyadviseur - als belangenbehartiger van de student dit geval - elkaar begrijpen en samenwerken aan het realiseren van de gewenste functionaliteit. Extra lastig is dat de wereld van XR voor gebruik in het onderwijs nog in de kinderschoenen staat.

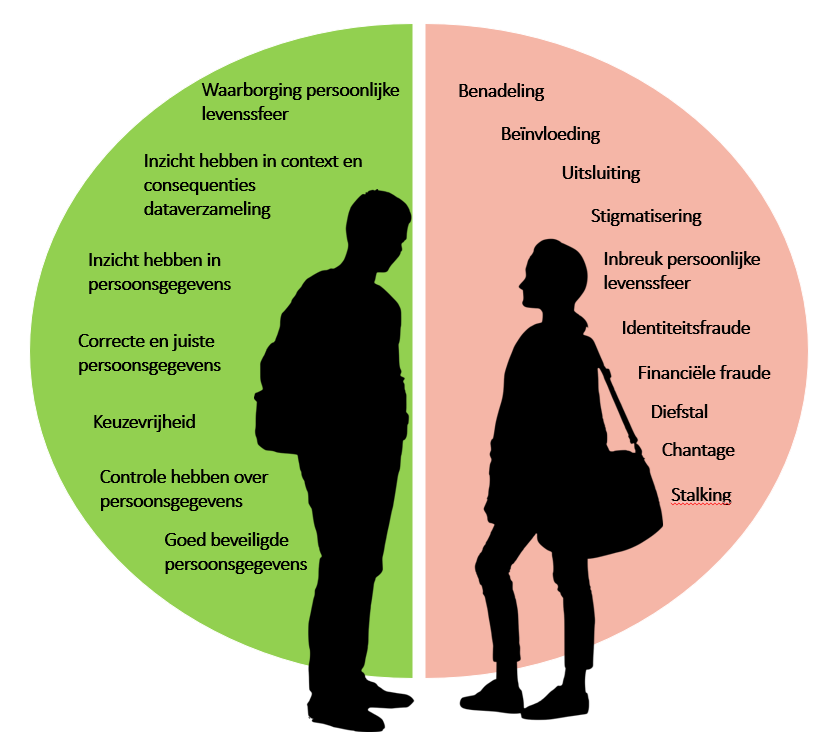

De student

Studenten zijn de zogenaamde 'betrokkenen' volgens de AVG. Ze hebben allerlei rechten als het gaat om de bescherming van hun persoonsgegevens. Gaat er iets mis , dan kan dat heel nadelige gevolgen hebben voor hen als persoon. Het kan in de fysieke wereld gevolgen hebben als digitale gegevens uitlekken.

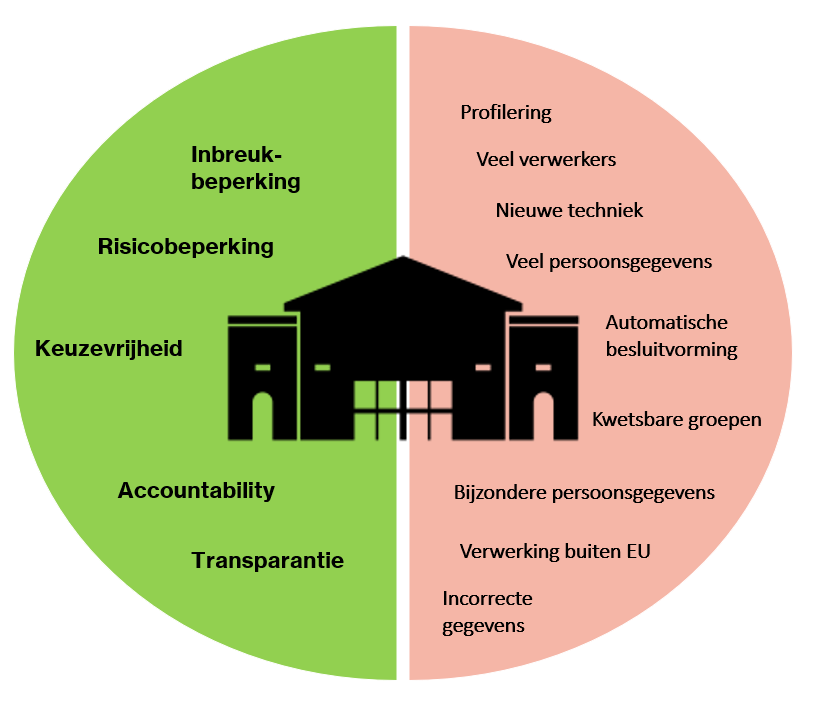

De onderwijsinstelling

De onderwijsinstelling is - ook voor de door jouw gekozen activiteiten als leraar - verantwoordelijk voor de persoonsgegevens die er binnen de organisatie worden verwerkt. De zogenaamde 'verwerkingsverantwoordelijke' volgens de AVG. Worden binnen de onderwijsinstelling op het gebied van privacy verkeerde keuzes gemaakt, dan kan dat heel slecht uitpakken (bijvoorbeeld reputatieschade, financiële schade).

Als leraar kun je het gevoel hebben dat je ergens in het midden klem zit …

Reële zorgen

Maar de zorgen zijn reëel. Een belangrijk privacyprobleem bij VR is het zeer persoonlijke karakter van de verzamelde gegevens. Denk aan biometrische gegevens zoals iris- of netvliesscans, vingerafdrukken en handafdrukken, gezichtsgeometrie en stemafdrukken. Maar ook het tracken van oogbewegingen en het opnemen van de omgeving met toevallige omstanders.

Bij XR is sprake van hyperpersonalisatie door de registratie van unieke patronen die jou maken wie je bent. Dat gaat ook over je cognitieve reactie, handbewegingen, lichaamssignalen, interessegebieden, angsten, emoties, stressfactoren, je fysieke en mentale conditie. De combinatie van gegevens leidt tot een set met informatie over jou, die je nooit aan anderen zou geven. Wat als de gegevens worden gehackt?

Een concrete situatie die tot problemen kan leiden is bijvoorbeeld het gebruik van smartglasses omdat vooroordelen kan versterken. Denk aan een sociale interactie, waarbij iemand een slimme bril met AI gebruikt. Die persoon trekt dan misschien al conclusies over jou op basis van je gezicht voordat degene jou als persoon daadwerkelijk kent. Dit kan leiden tot afwijzing en intimidatie.

Een ander voorbeeld is een veiligheidsprobleem in het verkeer die tot lichamelijk letsel leiden, bijvoorbeeld als er van onjuiste snelheidslimieten wordt uitgegaan.

Het beveiligen van XR-gegevens tegen ongeoorloofde toegang en het maken van de juiste implementatiekeuzes, zijn een cruciale uitdaging.

Dit allemaal nog los van het risico van verslaving en gezondheidseffecten zoals misselijkheid en desoriëntatie als je VR vaak of lang gebruikt.

Onbewust

Gebruikers zijn zich vaak onbewust wat er gebeurt als XR wordt toegepast. Ze weten niet:

- welke XR-gegevens worden verzameld

- wat de gevolgen van die verzameling kunnen zijn

- wanneer XR-gegevens worden verzameld

- waarom de gegevens nodig zijn

- dat gedragsgegevens zo gevoelig zijn

- wat de waarde van de XR-gegevens is

- hoe de gedragsgegevens kunnen worden misbruikt

- wat mogelijkheden zijn van misinformatie via XR

Bewustwording van gegevensgebruik en het verkrijgen van toestemming zijn nog niet algemeen gangbaar in de context van XR. We moeten op zijn minst gebruikers informeren wanneer hun gegevens in realtime worden verzameld.

Hoe dan wel?

Het niet weten hoe het werkt, leidt soms ook tot onverschilligheid. "Je kunt er toch niets aan doen". Maar net als met het online verbergen van je sporen: het kan wel beter! We moeten ervoor zorgen dat het volgende wordt toegepast:

- gegevens moeten in de eerste plaats worden gebruikt om de belangen van de gebruiker te dienen

- standaard privacyvriendelijke standaardinstellingen

- duidelijke informatie (geen moeilijk te lezen beleid dat mensen overslaan)

- gebruikersvoorkeuren toepassen

- handhaving en ontwikkeling van transparante XR-gegevenspraktijken (door de leverancier)

- vragen om applicaties die verschillende niveaus van privacy kunnen beheren

- normen opstellen voor XR-beveiliging, privacy en gegevens

Belangrijke vragen

We moeten bepalen wat er mogelijk mis kan gaan. Wat is het ergste dat je je kunt voorstellen dat er zou kunnen gebeuren? Concrete voorbeelden helpen om gemotiveerd te blijven om inspanningen te leveren om de gevolgen te beperken. Want je moet over een flink aantal zaken nadenken, zoals:

- Waar worden ‘XR’-gegevens door bedrijven opgeslagen, op het apparaat of in de cloud?

- Als ze in de cloud worden opgeslagen, worden de gegevens dan versleuteld?

- Delen bedrijven deze gegevens met derden? Zo ja, waarvoor gebruiken ze deze gegevens?

- Hoe controleren we de juistheid van de leerinhoud?

- Wat gebeurt er als het apparaat wordt gehackt?

- Kan de leverancier niet-gepersonaliseerde accounts aanbieden?

- Kan de student inloggen met een algemeen account van de school?

- Kun je (of de IT-afdeling) functies uitschakelen die persoonlijke gegevens verzamelen?

- Kun je handcontrollers gebruiken in plaats van handbewegingen vast te leggen?

- Kun je een voorgeprogrammeerd/vast leertraject volgen, zodat AI niet nodig is (vergelijk open antwoord met kraskaart of keuzekaart)?

- Kun je lokaal opslaan (bijvoorbeeld vanuit een opgenomen geluidsfragment) om controle te houden over het opslaan/vernietigen?

- Kun je de functionaliteit aanbieden zonder in te loggen?

- Kun je zelf de grenzen van een speelveld instellen, zodat de omgeving niet hoeft te worden gescand?

- Kun je het verzamelen van telemetrie en crashrapportages uitschakelen?

- Kun je een alternatief aanbieden aan de student?

- Kun je aanvullende afspraken maken met de leverancier?

De privacyadviseur/privacy officer van je organisatie kan helpen bij het maken van de (meestal vereiste) risicoanalyse (DPIA, Data Protection Impact Assessment). Uit die analyse blijkt welke risico's er zijn en hoe je die kunt verlagen.

Vervolgsessie Wild World of Privacy & XR

De vervolgsessie van Wild World of XR & Privacy vindt plaats op dinsdag 28 oktober van 13.00 tot 17.00 uur op het SURF-kantoor in Utrecht. We sluiten af met een drankje/netwerkgelegenheid.

Vervolgsessie Wild World of Privacy & XR

28 oktober 2025, 13.00 -17.00 uur